Worum es geht:

Wenn du KI entwickelst und Vorurteile verringern möchtest, musst du zuerst klarstellen, was „fair“ für dein System tatsächlich bedeutet.

Die Sache ist die: Es gibt keine einzige Definition von Fairness. Chancengleichheit? Demografische Parität? Gleiche Genauigkeit? Verfahrensgerechtigkeit? Diese Konzepte sind nicht nur akademisch; sie stellen tatsächlich unterschiedliche Ansätze dar, und die Optimierung für ein Konzept kann dem anderen entgegenwirken.

Dieses Board hilft dir, diese vier Definitionen zu erkunden, die Kompromisse zu verstehen und eine bewusste Entscheidung zu treffen, die zu deinem Kontext passt.

Was es dir bringt:

Eine klare, dokumentierte Fairness-Definition, die dein ganzes Team versteht und auf die sich alle einigen. Keine vagen Verpflichtungen mehr zu „fairer KI“, ohne zu wissen, was das eigentlich praktisch bedeutet.

Du wirst mit einer klaren Entscheidung und der dazugehörigen Begründung nach Hause gehen. Diese kann für das Design, das Testen und die Verfeinerung genutzt werden.

Wer am meisten profitiert:

Produktmanager, Datenwissenschaftler, KI-Ethik-Leads und funktionsübergreifende Teams, die KI-Systeme entwickeln, insbesondere in entscheidenden Bereichen wie Rekrutierung, Kreditvergabe oder Gesundheitswesen, bei denen es echte Konsequenzen hat, wenn die Fairness nicht stimmt.

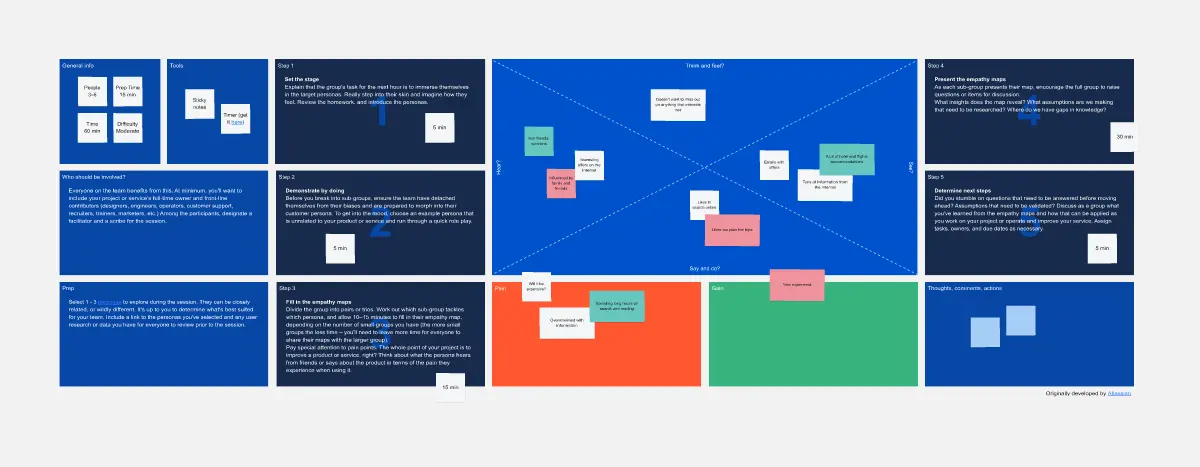

Wie man es anwendet:

Plane für deine erste Sitzung 45 Minuten ein. Arbeite mit deinem Team jede Fairness-Definition durch, diskutiere die Kompromisse offen und dokumentiere deine Wahl.

Gute Nachricht: Dies wird deine Grundlage für alle zukünftigen KI-Projekte; danach benötigst du nur noch 15 Minuten, um zu überprüfen und zu bestätigen, dass es weiterhin zutrifft.

Teil der Reihe "AI Bias Mitigation Workshop" (Boards 1 bis 4).