Le sujet :

Vous avez identifié vos groupes de parties prenantes à haut risque. Et maintenant ?

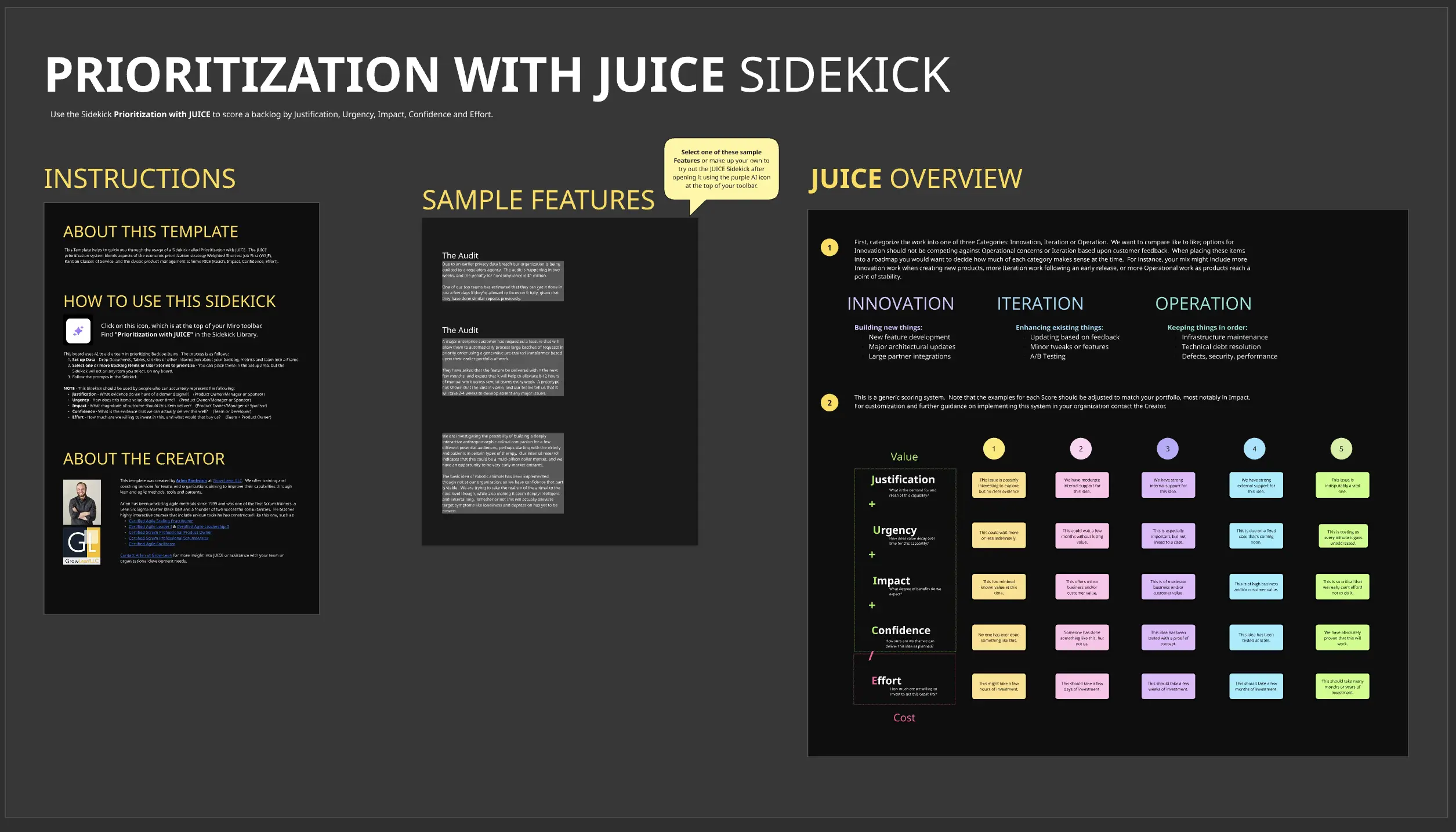

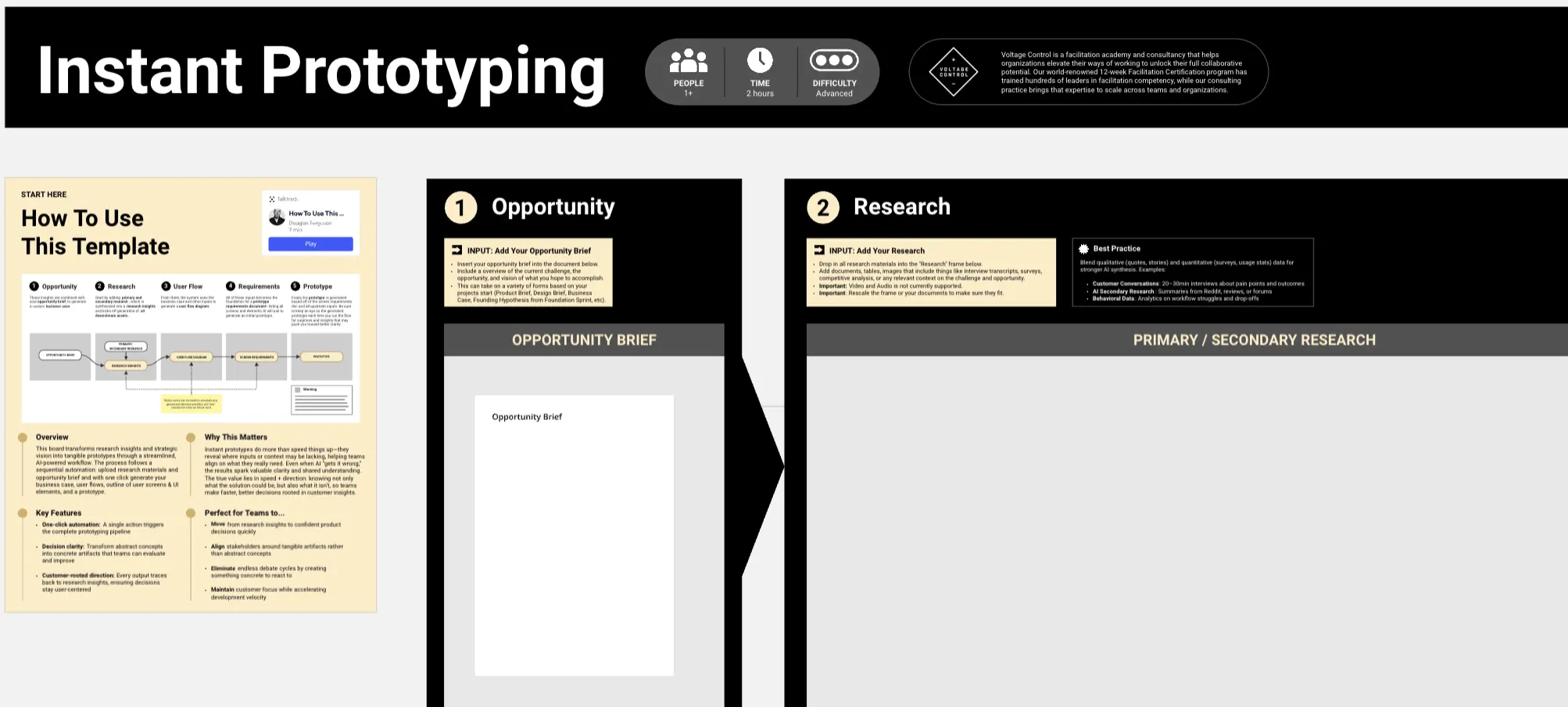

Ce tableau vous aide à sélectionner et planifier des interventions spécifiques pour atténuer le biais pour chaque groupe.

Vous choisirez parmi 21 options d'intervention réparties en six catégories, puis les organiserez selon un planning afin que vous puissiez déployer rapidement des protections à court terme tout en construisant des solutions à plus long terme.

Le concept clé ici est le Minimum Viable Fairness (MVF) : quel est le strict minimum à mettre en place pour déployer sans causer de préjudice ? Le parfait ne doit pas être l'ennemi du bien. Livrez d'abord le MVF, puis itérez.

Ce que cela vous permet d'accomplir :

Un plan d'intervention concret avec :

Protections immédiates : ce que vous pouvez mettre en œuvre dès maintenant

Correctifs à court terme : ce que vous pouvez livrer dans les prochaines semaines

Améliorations à moyen terme : ce que vous construirez au cours des prochains mois

Chaque intervention a un propriétaire clair, un planning et un indicateur de succès. Plus d'engagements vagues pour « aborder le biais plus tard ».

Qui en bénéficie le plus :

Responsables de produits, data scientists, chefs d'équipe technique et équipes cross-fonctionnelles qui doivent transformer les évaluations des risques en actions concrètes. Particulièrement utile pour les équipes sous pression qui doivent concilier rapidité et responsabilité.

Comment l'utiliser :

Prévoyez 60 à 90 minutes. Passez en revue vos groupes à haut risque issus du Tableau 3, associez-les aux interventions de la bibliothèque et définissez votre MVF.

** Utilisez le partenaire d'IA intégré pour obtenir des recommandations personnalisées basées sur votre profil de risque spécifique. Documentez tout dans le traqueur d’interventions pour ne rien laisser passer.

Partie de la série d'ateliers sur l'atténuation des biais IA (Tableaux 4 à 4).

Comprend un partenaire d'IA personnalisé pour vous aider à sélectionner et prioriser les interventions.