O czym jest ten przewodnik:

Jeśli budujesz system AI i dążysz do zmniejszenia uprzedzeń, najpierw musisz jasno określić, co "sprawiedliwość" naprawdę oznacza dla Twojego systemu.

Rzecz w tym, że nie ma jednej definicji sprawiedliwości. Równe szanse? Parzystość demograficzna? Równa dokładność? Sprawiedliwość proceduralna? To nie tylko abstrakcyjne pojęcia; to naprawdę różne podejścia, a optymalizacja jednego może działać na niekorzyść innego.

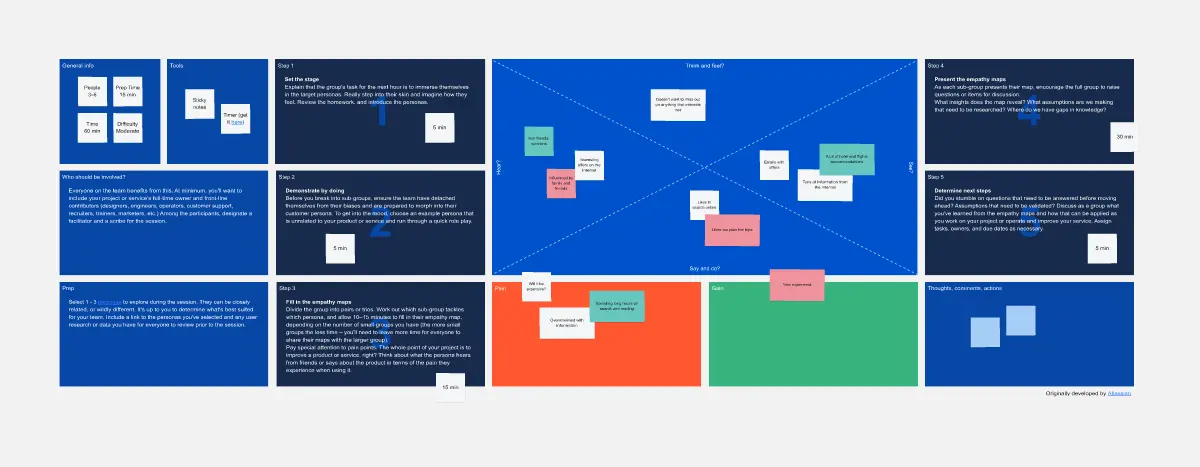

Ta tablica pomaga eksplorować te cztery definicje, zrozumieć kompromisy i świadomie wybrać rozwiązanie, które pasuje do Twojego kontekstu.

Co możesz osiągnąć:

Jasna, udokumentowana definicja sprawiedliwości, nad którą zgadza się cały Twój zespół. Koniec z niejasnymi zobowiązaniami do "sprawiedliwego AI" bez znajomości tego, co to faktycznie oznacza w praktyce.

Uzyskasz konkretną decyzję i jej uzasadnienie. Może być używana do projektowania, testowaniu i udoskonalania.

Kto skorzysta najbardziej:

Menedżerowie produktowi, naukowcy zajmujący się danymi, liderzy ds. etyki AI i zespoły międzyfunkcyjne budujące systemy AI, szczególnie w obszarach wysokiego ryzyka, takich jak rekrutacja, udzielanie pożyczek czy opieka zdrowotna, gdzie brak sprawiedliwości ma realne konsekwencje dla ludzi.

Jak z tego korzystać:

Przeznacz 45 minut na pierwszą sesję. Pracujcie razem z zespołem nad każdą definicją sprawiedliwości, uczciwie omówcie kompromisy i udokumentujcie swój wybór.

Dobra wiadomość: To staje się podstawą wszystkich przyszłych projektów AI; później wystarczy tylko 15 minut na weryfikację i potwierdzenie, że nadal jest aktualna.

Część serii warsztatów dotyczących łagodzenia stronniczości AI (Tablice 1 do 4).