Les données sont le pilier des entreprises modernes. Les équipes les utilisent pour obtenir des insights sur le comportement de la clientèle, auditer et optimiser leurs opérations, prévoir les évènements futurs et découvrir les tendances cachées qui peuvent contribuer à la croissance.

Si les données sont essentielles, de nombreuses entreprises ont encore du mal à les exploiter efficacement. Par exemple, leurs ensembles de données peuvent être vastes, déconnectés ou cloisonnés dans de nombreuses plateformes. Il peut donc être très difficile de les agréger et d’en tirer des insights tangibles susceptibles de générer des changements positifs.

Heureusement, il existe des outils pour vous y aider, notamment Azure Data Factory. Dans cet article, nous allons nous pencher sur cet outil, ses avantages et la façon dont vous pouvez l’utiliser dans votre entreprise pour transformer vos données en actions.

Qu’est-ce qu’Azure Data Factory ?

Azure Data Factory (ADF) est un service d’intégration de données basé sur le cloud de Microsoft qui permet aux entreprises de créer, de gérer et d’automatiser des pipelines de données.

ADF aide les entreprises à déplacer, à transformer et à gérer efficacement leurs données entre différents systèmes, qu’ils soient dans le cloud ou sur site.

En rationalisant et en automatisant ces processus, ADF garantit que les données sont toujours à jour et prêtes à être analysées à tout moment. Cet atout est essentiel pour les entreprises modernes et dispersées qui dépendent fortement des données pour prendre rapidement des décisions stratégiques.

Dix avantages d’Azure Data Factory

Par nature, Azure Data Factory peut aider les entreprises à simplifier leurs processus de données et à améliorer leur efficacité. C’est donc un outil puissant pour automatiser l’intégration des données et améliorer les résultats commerciaux.

Voici 10 avantages d’ADF à connaitre :

- Automatisation de l’intégration des données. ADF prend en charge le déplacement et la transformation des données entre les systèmes, ce qui fait gagner du temps et réduit la nécessité de les traiter manuellement.

- Réduction de la charge de travail du service IT. ADF est basé sur le cloud. Vous n’avez donc pas à mettre en place ou à maintenir des serveurs. Vous réduisez ainsi la charge de travail et les coûts opérationnels du service IT.

- Compatibilité avec de nombreuses sources de données. Que vos données soient stockées dans le cloud ou sur site, ADF s’intègre à un grand nombre de plateformes, ce qui facilite la gestion centralisée de toutes vos données.

- Facilité d’utilisation pour toutes les équipes. Grâce à son interface simple de type glisser-déposer, n’importe quel utilisateur non expert peut créer des workflows de données, tandis que les utilisateurs plus connaisseurs pourront utiliser du code si nécessaire.

- Automatisation en temps réel et programmée. ADF vous permet de planifier des tâches relatives aux données ou de les déclencher automatiquement suite à des évènements, ce qui garantit que vos données sont toujours à jour.

- Extensibilité en fonction de votre croissance. ADF peut traiter des volumes de données croissants à mesure que votre entreprise se développe. Vous ne payez que pour ce que vous utilisez et maitrisez ainsi davantage les coûts.

- Amélioration de la prise de décision. En automatisant l’intégration et le traitement des données, ADF garantit que les données en temps réel sont toujours disponibles. Vous pouvez donc prendre plus rapidement des décisions basées sur les données.

- Prise en charge des analyses avancées. Grâce à son intégration facile aux plateformes d’apprentissage automatique et d’analyse, ADF aide les entreprises à exploiter leurs données pour en tirer des insights et des modélisations prédictives.

- Sécurité des données. Les fonctions de sécurité intégrées et les outils de conformité d’ADF protègent vos données et garantissent que les pratiques de gestion des données de votre entreprise respectent les normes règlementaires, une exigence cruciale dans des secteurs comme la finance et la santé.

- Réduction des erreurs manuelles. En automatisant les workflows de données complexes, ADF minimise le risque d’erreurs humaines susceptibles de survenir lors du traitement manuel des données, ce qui améliore la précision des résultats.

Voyons maintenant comment cela fonctionne.

Fonctionnement d’ADF : les bases

ADF facilite le déplacement et la transformation des données en cinq étapes clés :

- Ingestion

- Flux de contrôle

- Flux de données

- Planification

- Surveillance

Voici un exemple pour illustrer ce qui se passe à chaque étape.

Une grande entreprise du secteur de la distribution qui opère dans plusieurs régions du monde a besoin de nettoyer et de centraliser ses données de vente à partir de l’exercice 2024. Ses dirigeants auront besoin de ces données pour effectuer une analyse en temps réel et asynchrone de leurs performances commerciales afin de faciliter la planification stratégique et l’établissement du budget de l’exercice à venir.

Voici comment ADF peut les aider.

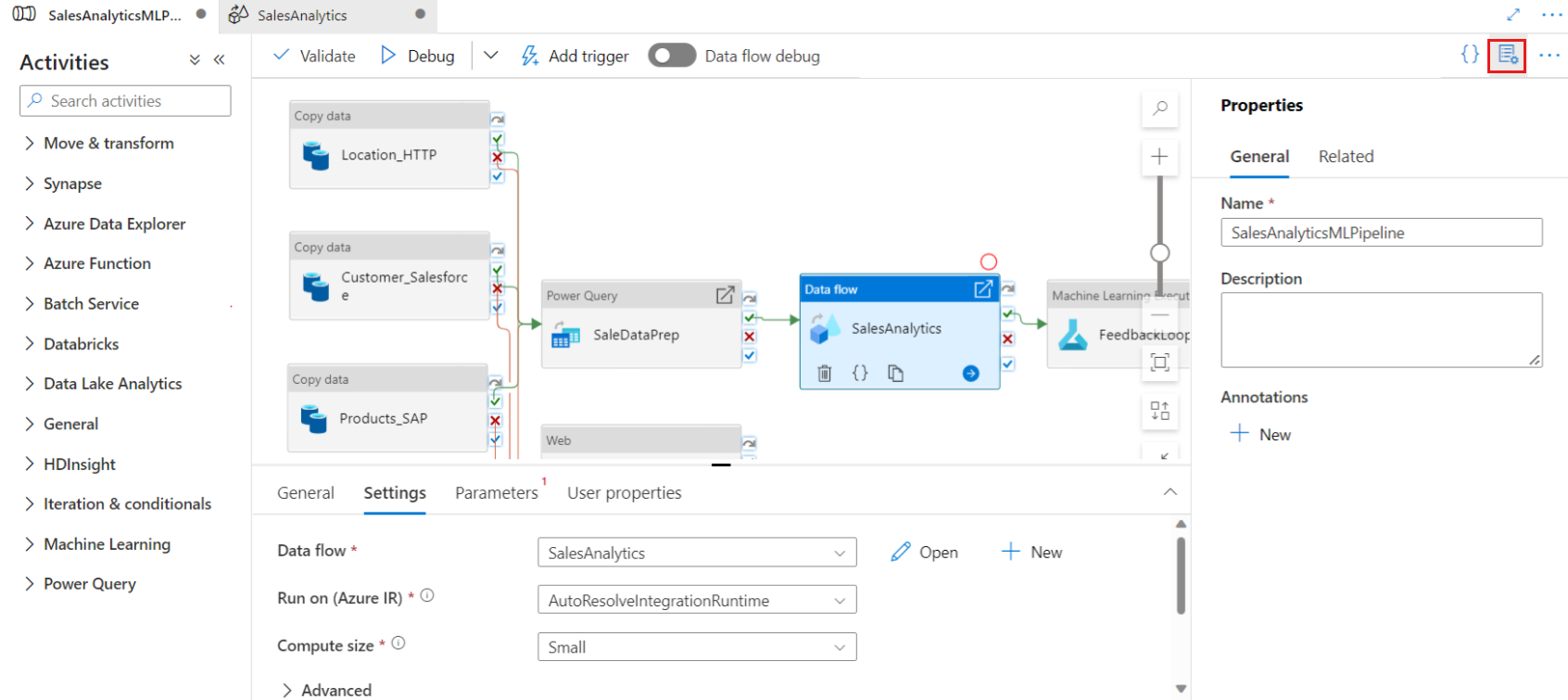

- Ingestion. Tout d’abord, ADF se connecte à de multiples sources telles que les bases de données de vente, le stockage dans le cloud et les API des magasins régionaux, et rassemble les données dans un référentiel central en vue de leur traitement.

- Flux de contrôle. ADF orchestre ensuite une séquence d’actions, en veillant d’abord à collecter les données de toutes les régions, puis à les traiter pour assurer leur cohérence, les tâches étant automatiquement déclenchées à la fin de chaque étape. Ces actions comprennent la collecte de données, la transformation (comme le nettoyage ou l’agrégation de données), l’application d’une logique conditionnelle pour traiter les erreurs et l’intégration à des services externes comme des plateformes d’analyse ou d’apprentissage automatique.

- Flux de données. Une fois ces actions terminées, ADF nettoie et transforme les données de vente en supprimant les doublons, en agrégeant les totaux et en formatant le tout pour produire des rapports, sans qu’il soit nécessaire d’effectuer un codage approfondi.

- Planification. Les pipelines ADF peuvent ensuite être configurés pour s’exécuter quotidiennement (ou à d’autres intervalles de temps spécifiés) afin de garantir que les données de vente de chaque région sont mises à jour automatiquement et disponibles pour la prise de décision en cas de besoin.

- Surveillance. Enfin, ADF assure une surveillance en temps réel du pipeline, ce qui permet à l’entreprise de suivre les performances, d’identifier et de résoudre les problèmes et de s’assurer que le traitement des données reste fluide et efficace.

En suivant ce workflow, l’entreprise du secteur de la distribution peut intégrer et gérer les données de tous ses sites de manière transparente, ce qui lui permet d’obtenir en temps voulu des insights fiables sur ses performances de vente.

Comment se lancer avec Azure Data Factory ?

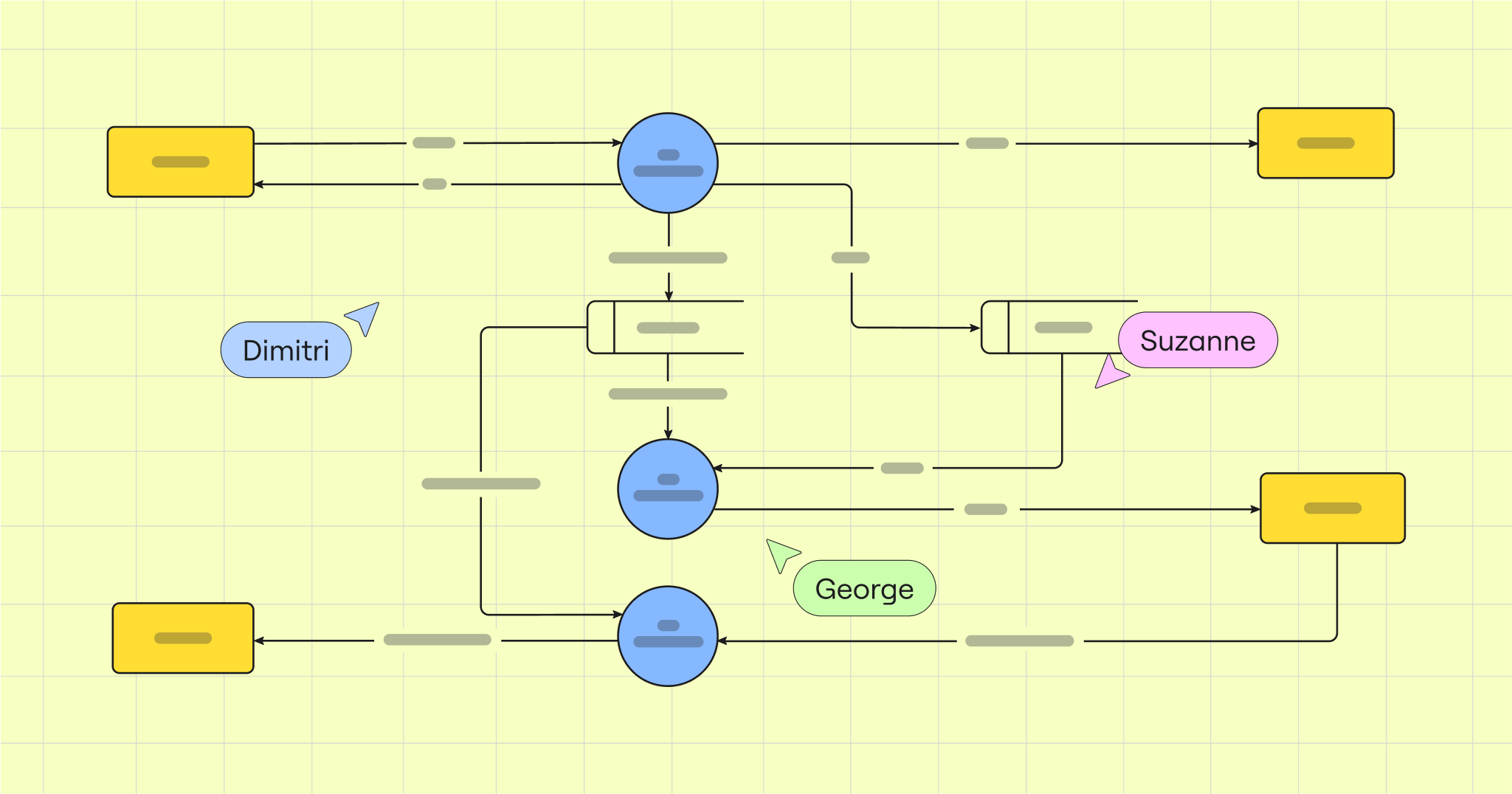

La première étape de l’utilisation d’Azure Data Factory consiste à concevoir vos pipelines de données à l’aide du concepteur ADF. Cet outil visuel facilite la création de pipelines qui définissent la manière dont les données sont déplacées et transformées entre les différentes sources et destinations.

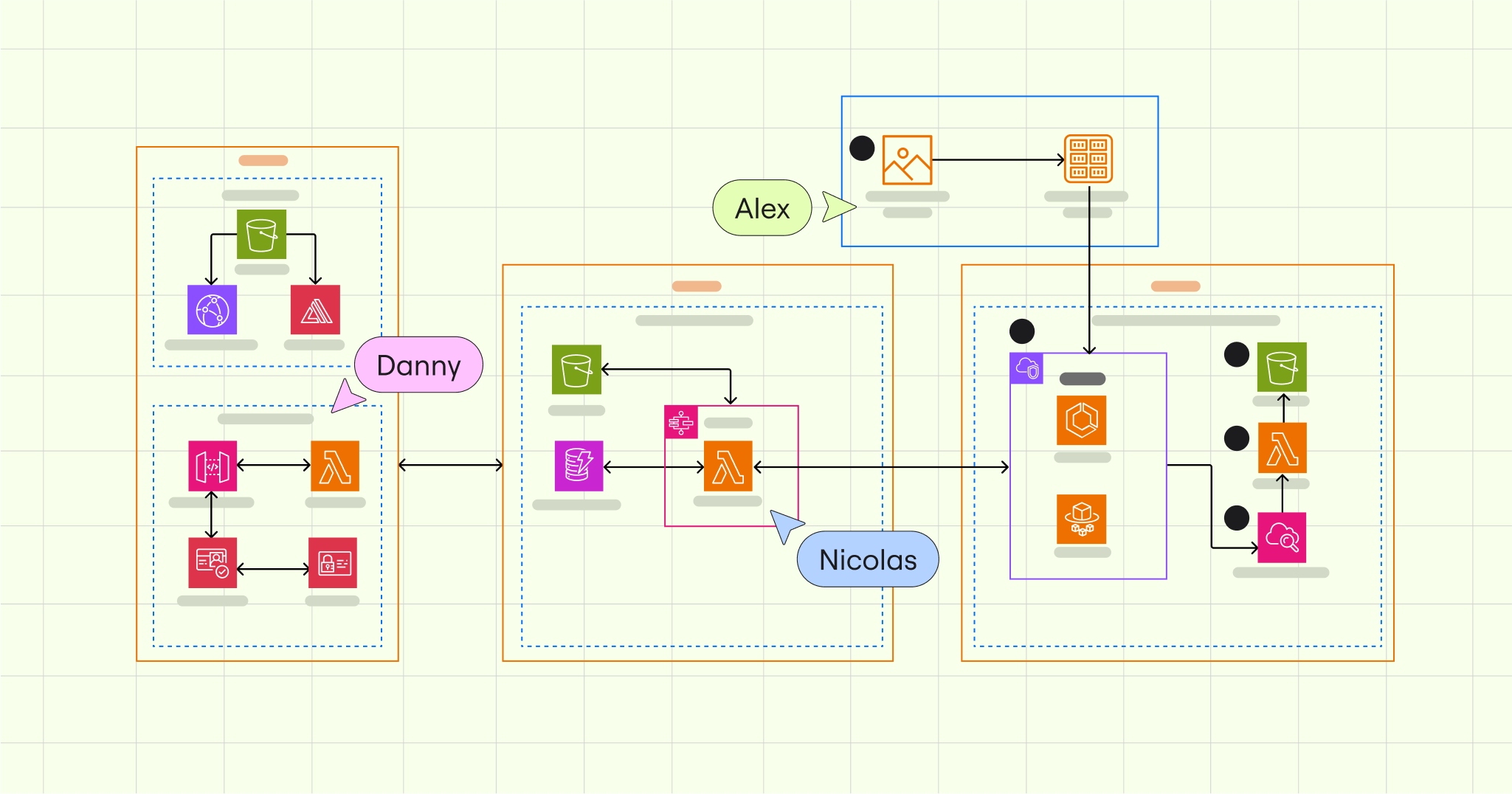

Ensuite, utilisez un outil de création de diagrammes visuel comme le modèle de diagramme d’architecture Azure de Miro pour cartographier votre cadre de flux de données. Ce modèle aide à organiser visuellement des workflows de données simples ou complexes, en assurant une planification claire avant leur mise en œuvre.

En prime, les modèles Miro sont entièrement collaboratifs et partageables. Votre équipe et les principales parties prenantes peuvent ainsi collaborer à distance sur vos documents de planification, en temps réel ou de manière asynchrone.

Une fois votre cadre en place, configurez les services liés pour connecter ADF à vos sources de données, telles que des bases de données SQL ou un stockage dans le cloud.

Ensuite, définissez les ensembles de données qui détaillent l’origine et la destination de vos données. Les ensembles de données dans ADF représentent des structures de données spécifiques (comme les tableaux, les fichiers ou les blobs) que la plateforme va lire ou sur lesquelles elle va écrire pendant l’exécution du pipeline. Ils permettent de s’assurer que les données adaptées sont utilisées et traitées à chaque étape du workflow.

Enfin, créez un flux de données (par exemple en filtrant les informations inutiles, en nettoyant les incohérences ou en agrégeant les données dans des résumés) pour préparer vos données pour l’analyse.

Connectez, analysez et exploitez vos données

La création et le stockage des données ne sont pas le principal problème des entreprises modernes. Si c’était le cas, les études ne prévoiraient pas que le monde produira environ 180 zettaoctets de données en 2025 (contre 64,2 zettaoctets en 2020).

Le problème est de connecter les données. ADF est un outil essentiel pour les entreprises qui disposent de pools de données vastes mais déconnectés les uns des autres. Il permet de connecter, d’agréger et de normaliser les données. Vous pouvez ainsi tirer des insights significatifs susceptibles de faire progresser votre entreprise.